vLLM本地部署和Dify中大模型的调用教程

一、前置准备

在 Ubuntu 上安装 Conda 环境可以通过安装Miniconda 来完成。以下是详细的步骤:

二、安装 Miniconda

2.1 下载 Miniconda 安装脚本

使用 wget 或 curl 下载 Miniconda 安装脚本:

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

或:

curl -O https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

2.2 安装 Miniconda

给予安装脚本执行权限:

chmod +x Miniconda3-latest-Linux-x86_64.sh

运行安装脚本:

bash Miniconda3-latest-Linux-x86_64.sh

按提示操作,阅读并接受许可协议,选择安装路径(默认即可),并决定是否将 Conda 的 bin 目录添加到环境变量中。

2.3 初始化 Conda

安装完成后,运行以下命令初始化 Conda:

conda init

重新打开终端,以使更改生效。

2.4 验证安装

输入以下命令检查 Conda 版本:

conda --version

如果显示版本号,则安装成功。

三、创建和管理 Conda 环境

3.1 创建新的 Conda 环境

使用以下命令创建一个新的 Conda 环境,并指定 Python 版本:

conda create -n myenv python=3.8

其中 myenv 是环境名称,python=3.8 指定了 Python 版本。

3.2 激活环境

激活已创建的环境:

conda activate myenv

3.3 列出所有环境

查看所有已创建的 Conda 环境:

conda env list

3.4 删除环境

删除不需要的 Conda 环境:

conda remove -n myenv --all

3.5 在环境中安装包

在激活的环境中,使用以下命令安装包:

conda install numpy

四、VLLM部署

4.1 创建conda环境

conda create -n vllm python=3.104.2 安装vLLM

pip install vllm -i https://pypi.tuna.tsinghua.edu.cn/simple4.3、下载modelscope

modelscope是模型管理工具,用来管理模型的下载、上传、版本管理等。

pip install modelscope -i https://pypi.tuna.tsinghua.edu.cn/simple4.4、模型下载

modelscope download --model Qwen/Qwen3-8B --local_dir /home/hoyooai/models4.5、启动服务

vllm serve models/Qwen3-8B --port 8000 --host 0.0.0.0 --dtype=half --gpu_memory_utilization 0.5host: 0.0.0.0 允许外部访问

dtype: half 使用半精度浮点数,如果你使用的是N卡30系及以上,可以使用dtype=float16

gpu_memory_utilization: 0.5 使用GPU的50%的显存

4.6、获取服务地址

在wsl中运行如下命令:

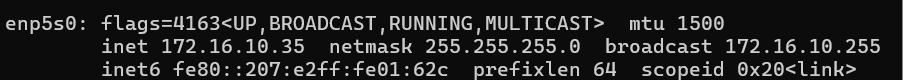

ifconfig# 如果提示未安装sudo apt-get install net-tools # 安装net-tools获取得到的宿主机ip地址为172.16.10.35。

4.7、通过api访问服务

4.7.1、构建api请求

curl -X POST 'http://172.16.10.35:8000/v1/chat/completions' \--header 'Content-Type: application/json' \--data-raw '{ "model": "models/Qwen3-8B", "messages":[ {"role":"system","content":"you are hoyooai"}, {"role":"user","content":"你好"} ]}'

4.7.2、下载postman

postman是一款api测试工具,可以用来测试api接口。

下载地址:https://www.postman.com/downloads/

4.7.3、导入api请求

将上述api请求import。

请求方式为POST,请求头中Content-Type为application/json,请求体为:

{ "model": "models/Qwen3-1.7B", "messages":[ {"role":"system","content":"you are eogee"}, {"role":"user","content":"你好"} ]}点击send,如提示wsl命令行中提示未安装GCC编译器

可以执行如下命令:

conda install gcc_linux-64 gxx_linux-64五、Dify中访问服务

在Dify中,选择OpenAI-API-compatible作为模型提供商

添加模型,在模型名称中输入models/Qwen3-1.7B

在API endpoint URL中输入http://172.21.56.14:8000/v1

点击添加,完成模型添加。