使用llama-factory进行模型训练与微调

1. 目的

本文档介绍如何准备环境,以及如何安装conda和llama-factory等工具。

使用llama-factory预置的数据集进行模型的简单训练。

2. conda 的安装

2.1 环境准备

安装 CUDA :访问 NVIDIA 官网,根据你的 GPU 型号和系统版本选择合适的 CUDA 版本进行安装。安装完成后,通过命令

nvcc -V和nvidia-smi验证安装是否成功。安装 Anaconda :到 Anaconda 官网下载对应系统的安装包并安装。安装完成后,通过

conda --version验证安装成功。

2.2 创建虚拟环境

使用以下命令创建并激活新的虚拟环境:

conda create --name hoyoo python==3.11

conda activate hoyoo

2.3 安装 Pytorch

根据你的 CUDA 版本,在 Pytorch 官网查找适配的安装命令。例如,CUDA 版本为 12.1 时,可使用以下命令:

conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.1 -c pytorch -c nvidia

pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu126

安装完成后,

通过 python -c "import torch; print(torch.cuda.is_available())" 验证是否成功安装 GPU 版本的 PyTorch。

2.4 克隆项目仓库

确保已安装 Git,然后执行以下命令克隆 LLaMA-Factory 仓库:

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

2.5 安装项目依赖

先升级 pip 版本,再安装项目依赖:

python -m pip install --upgrade pip

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/

pip install -e ".[torch,metrics]" -i https://pypi.tuna.tsinghua.edu.cn/simple/

2.6 安装 Rust 和 Cargo

如果安装过程中提示缺少 Rust 和 Cargo,可通过以下命令安装:

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

source $HOME/.cargo/env

将 export PATH="$HOME/.cargo/bin:$PATH" 添加到 Shell 配置文件中,如 ~/.bashrc,然后执行 source ~/.bashrc 使配置生效。

2.7 验证安装

安装完成后,可以通过以下命令启动 LLaMA-Factory 的 WebUI 界面,并在浏览器中输入 http://localhost:7860/ 访问,查看是否能够正常使用:

llamafactory-cli webui

3. LLaMA-Factory模型训练

3.1 LLaMA-Factory 简介

LLaMA-Factory 是一个简单易用且高效的大型语言模型训练与微调平台,适合初学者和有一定经验的开发者。以下是使用 LLaMA-Factory 进行模型训练与微调的详细步骤:

3.2 环境准备

3.2.1 安装依赖环境

构建虚拟环境:

conda create -n llamafactory python=3.10 -y && conda activate llamafactory

安装 LLaMA-Factory:

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e .

3.2.2 校验安装

执行以下命令检查版本:

llamafactory-cli version

3.3 启动 LLaMA-Factory

在 LLaMA-Factory 的目录下运行以下命令启动 Web 界面:

llamafactory-cli webui

如果需要在后台运行,可以使用以下命令:

nohup llamafactory-cli webui &

启动后,使用浏览器访问 http://0.0.0.0:7860

3.4 选择被训练模型

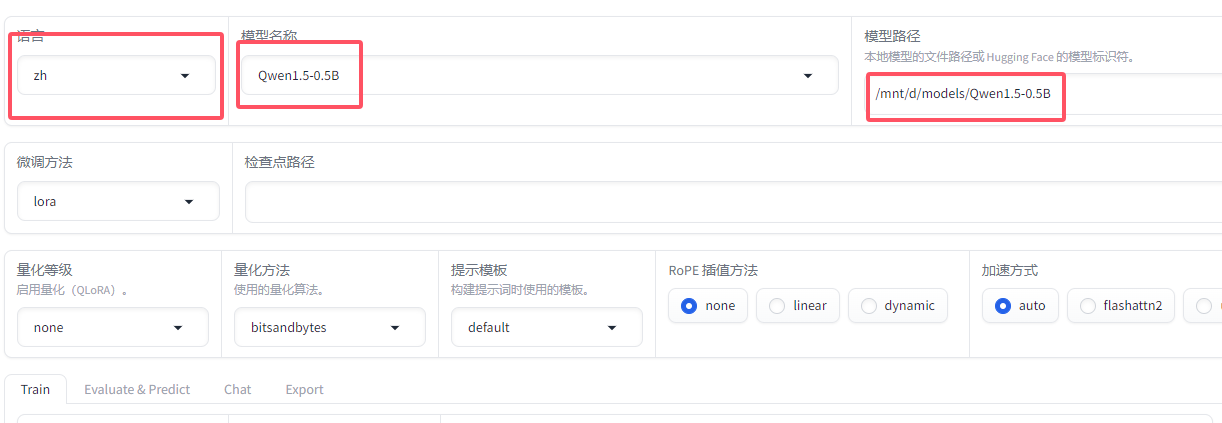

你可以提前在hf-mirror下载得到QWEN1.5-0.5B模型,我们选取已知最小的模型用于测试。hf-mirror网址: https://hf-mirror.com/

下载完成后,解压压缩包,得到Qwen1.5-0.5B文件夹。你可以将其拷贝到D:\models目录下。

由于我们在ubantu环境下进行训练,需要在模型路径中填写ubantu系统中的相对路径,如:

/mnt/d/models/Qwen1.5-0.5B

你可以在右上角将语言设置为zh中文,以便阅读。

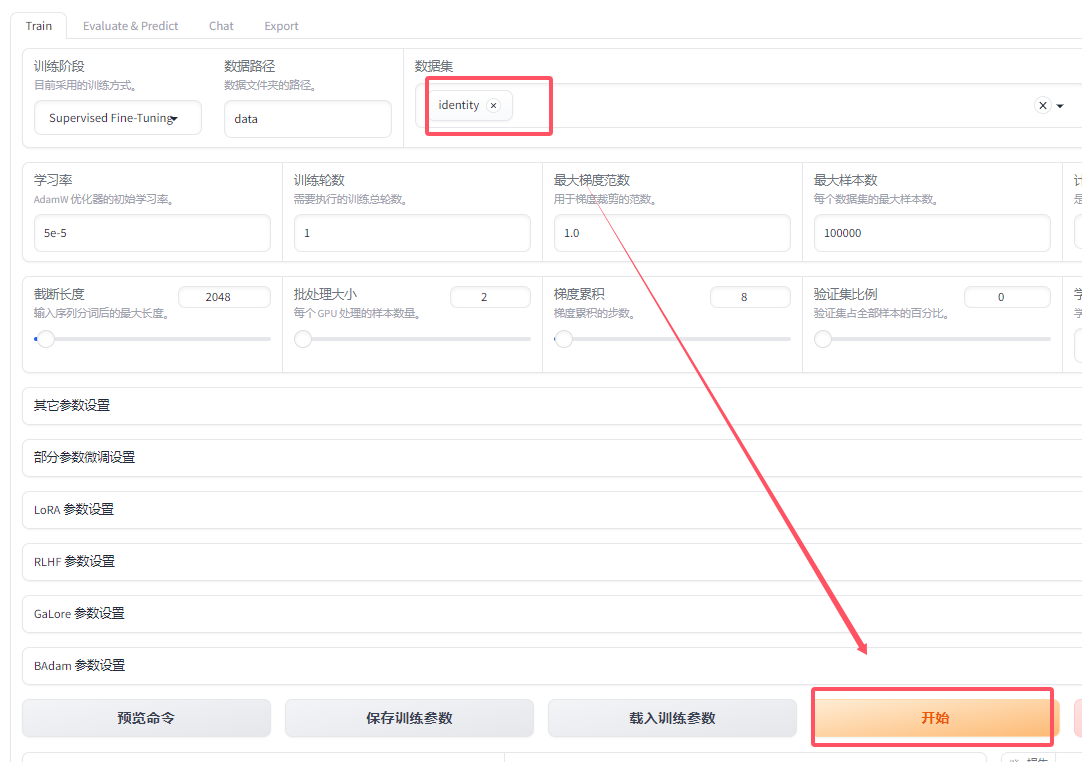

3.5 调整训练参数,选择数据集

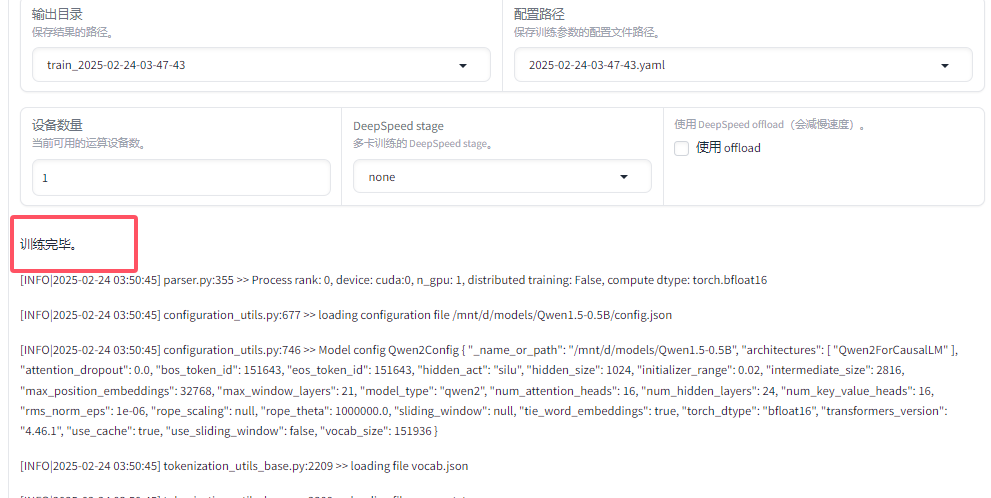

我们在界面下方选择llama-factory的自带的数据集identity,选择训练轮数为1,选择梯度为1,以加快训练速度(这种训练参数的设置会造成训练效果不好的状况,此处仅作演示)。设置完成后,点击开始训练按钮。

当界面中提示训练完成,即表示我们本次模型训练初体验成功。