Lmstudio本地部署DeepSeek 及部署后的性能调节

0. 前言

上一节内容讲到Ollama部署deepseek的方法,会有下面几方面问题:

Ollama官网访问安装包下载失败

下载deepseek模型文件过慢或失败

在不进行环境配置的情况下,默认安装至C盘,导致空间不足

一部分Nivida显卡无法吃满显存资源

一部分AMD显卡替换rocm文件后无法启动

下面给大家介绍Lm studio本地部署DeepSeek的方法,并进行性能调节。以解决上述问题.

资源获取

本文档中的所有下载的所需资源都可以在网盘下载或在右上角的群内容获取。

1. 下载及安装Lm studio

Lm studio 部署、管理、调节的软件,可以免费下载使用。

Lm studio官网:(点击访问官网):[https://lmstudio.ai/]

网盘文件名:LmStudio.exe

下载完成后,双击安装包一路下一步安装即可。

安装完成后,打开Lm studio,点击左上角skip跳过,进入模型对话界面。

2. 设置模型读取位置

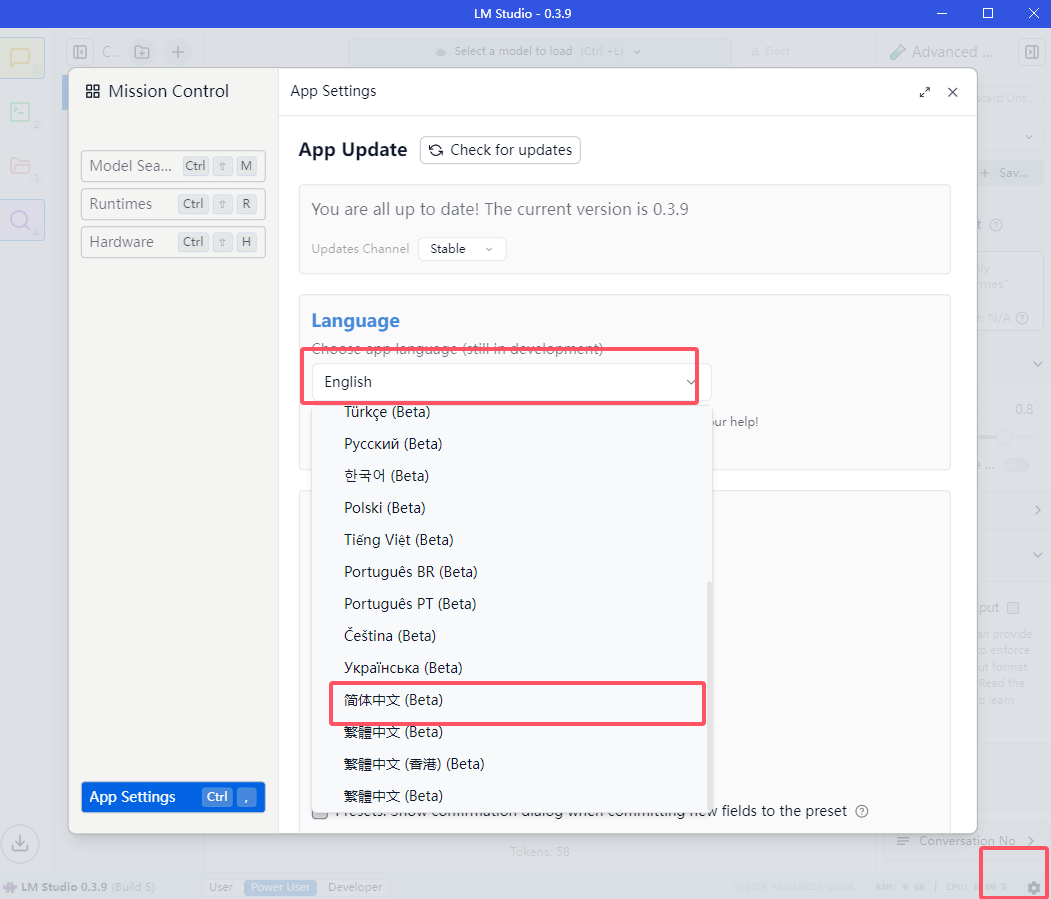

修改语言:

点击右下角设置图标,点击language,选择简体中文。

设置模型读取位置:

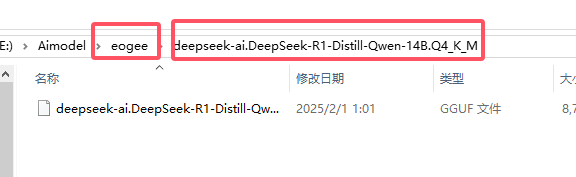

点击左上角文件夹图标修改模型读取位置。可以设置为你磁盘空间比较大的位置。

点开对话框后,在你要选择的文件夹下,新建二级文件目录,如:/eogee/deepseek-8b。

这里的第一个目录是模型提供者,第二个目录是模型名称。都给可以自定义为任何内容,但需要注意每个模型要有一个单独的目录。

上图所示即为二级目录。

注意:前后一共三级目录,选择模型目录须选择最上层。

3. 下载DeepSeek模型文件

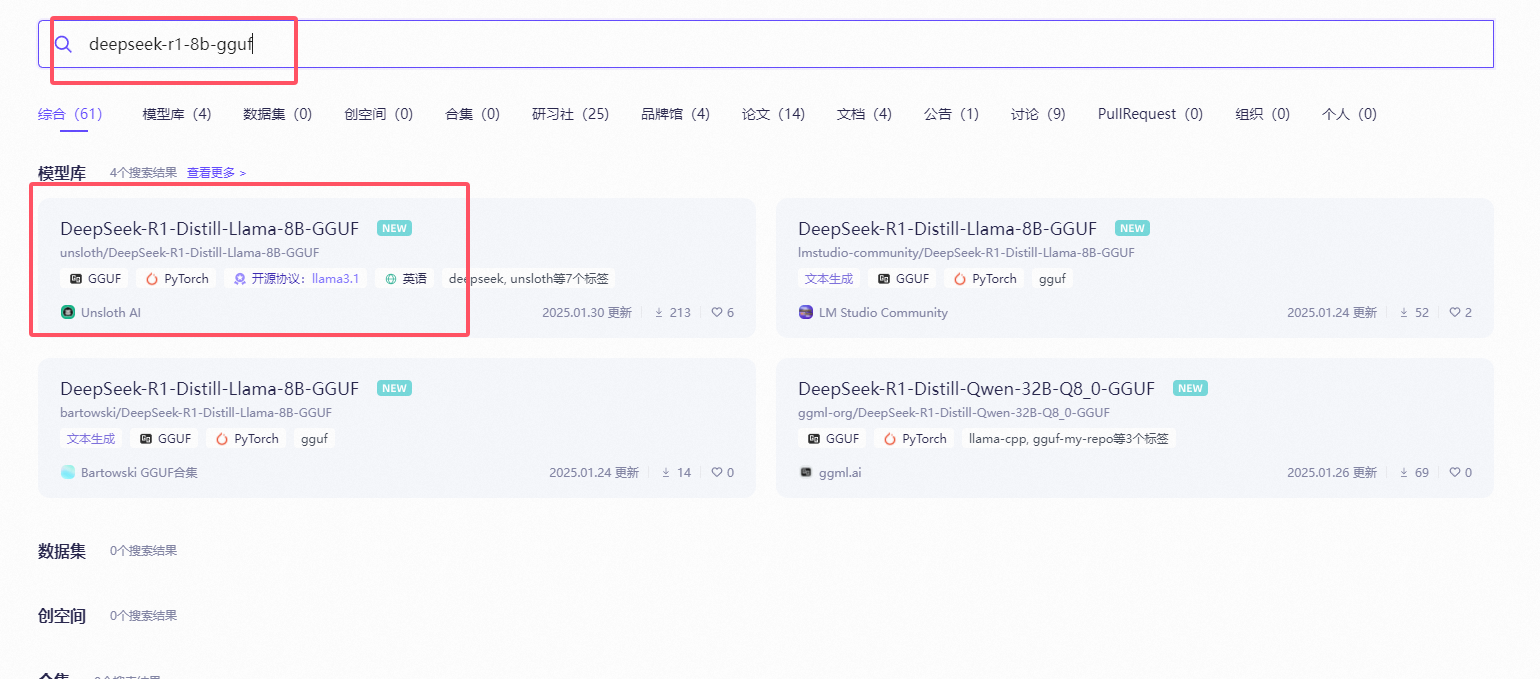

访问魔塔社区(一个国内的开源模型社区,他不需要科学上网,也不需要使用镜像,可以直接下载模型,对国内用户友好),下载DeepSeek模型文件。

经其他群友分享及测试,在hf-mirror.com复制下载链接,在迅雷(无需登录账号、开通会员)中粘贴链接下载更快速(2025年2月13日新增)。

在搜索栏中搜索 deepseek-r1-8b-gguf,进入页面后,点击模型和文件,进入模型列表页面,选择合适的模型进行下载。

下载完成后,将模型移动到我们刚建好的模型读取目录中即可。

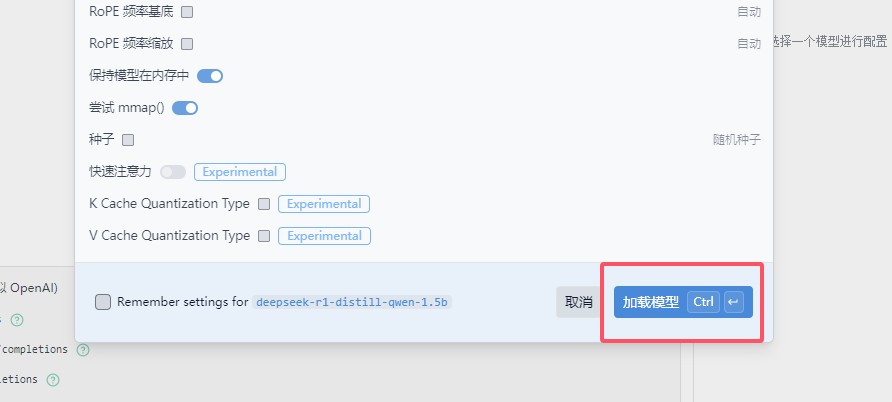

4. lm studio 选择并加载模型

在lm studio界面上方,选择你刚安装的模型,点击下方的按钮加载模型。

静等片刻,模型加载完成后,在下方的输入框就可以向deepseek提问了。

5. 模型加载性能性能调节(如何能吃满显存)

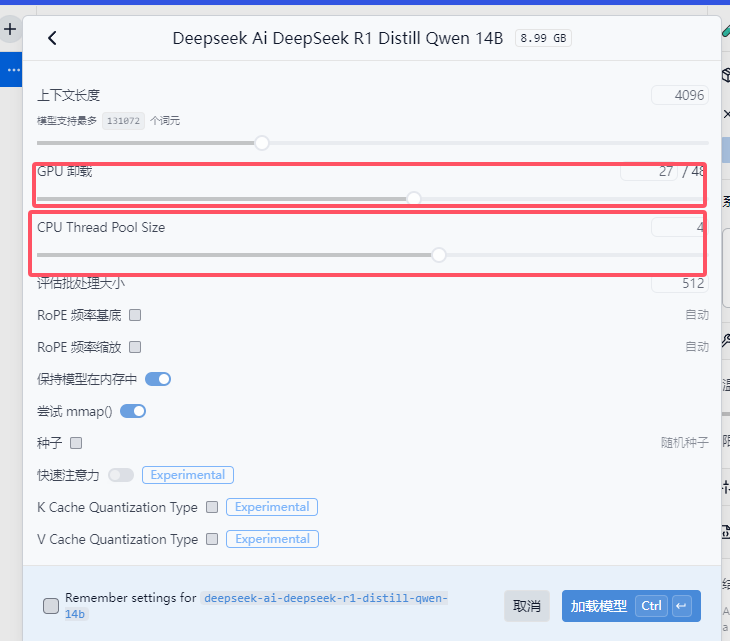

模型加载参数:

第一个选项条表示上下文长度,非特殊情况不建议更改。

第二个选项条表示模型加载消耗的显存资源,越大占用越多,调整时注意观察你自己设备的性能状况。

第三个选项条表示模型加载的CPU线程数,可以适当调整。

响应参数:

你可以通过右侧的 系统提示 设置每次提问的默认前缀。

设置 温度 来调整推理结果的 天马行空 程度,越高越离谱,越低越严谨,再非文学创作的情况下不建议调整。

其他设置项默认即可。