Dify在windows系统的docker中向本地部署的deepseek嵌入知识库提问

目的

windows 安装docker

本地部署 deepseek(ollama)

本地部署 dify 并嵌入 知识库

资源获取

本文档中的所有下载的所需资源都可以在网盘下载或在右上角的群内容获取。

1.设置windows环境

开启Hyper-V

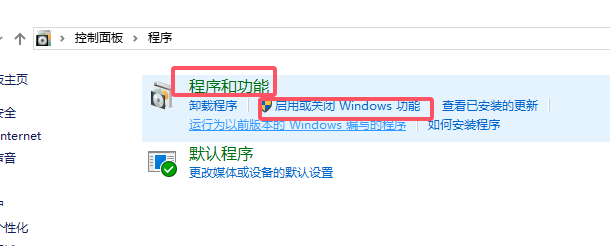

打开 控制面板 - 程序 - 启动或关闭windows功能

在对话框中分别选中打开:

Hyper-V

容器

适用于Linux的Windows子系统(WSL2)

虚拟机平台

点击 确定 重启电脑。

开启WSL2

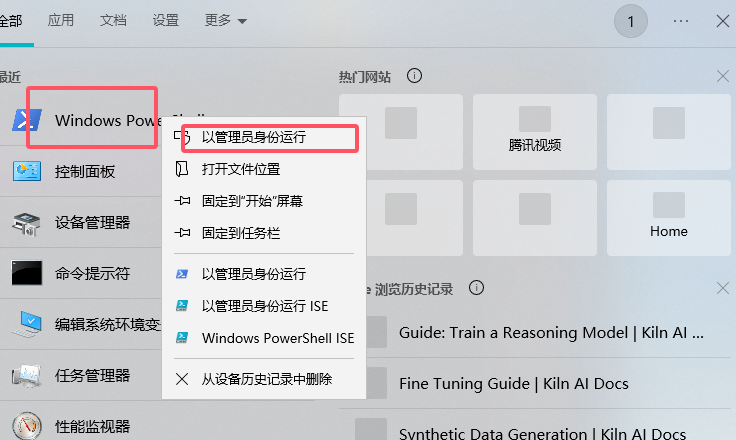

打开PowerShell(右键以管理员身份运行)

运行以下命令:

wsl --install如果没有启动安装,你需要下载并安装适用于你的 Windows 版本的 WSL2 Linux 内核更新包。

点击此处,下载适用于你的 Windows 版本的 WSL2 Linux 内核更新包。

网盘文件名:wsl_update_x64.msi

下载完成后,双击安装包,按照提示完成安装。

如果仍然报错,并显示无法访问github,则需要修改代理:

打开命令提示符或PowerShell。

输入以下命令来设置代理:

netsh winhttp set proxy 127.0.0.1:1080或修改Hosts文件绕过DNS污染:

打开C:\Windows\System32\drivers\etc\hosts文件(以管理员身份运行记事本)。

在文件末尾添加以下行并保存:

185.199.108.133 raw.githubusercontent.com保存完成后,回到powershell继续执行命令:

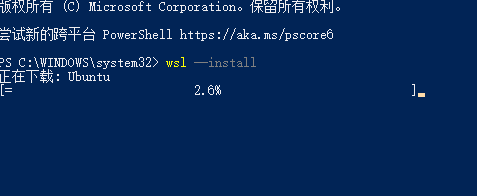

wsl --install如显示下载ubantu镜像包,请耐心等待,如下所示:

如果仍然报错,执行命令wsl --update对wsl进行更新。

如果更新后仍然出现错误,表示需要修改bios设置,则需要修改bios中的虚拟化设置。

开启虚拟化

打开BIOS,找到虚拟化设置,开启VT-x或AMD-V。

各个电脑的BIOS设置可能不同,请根据自己的电脑具体操作。

重启电脑。

2.安装docker

下载docker安装包

访问docker官网:https://www.docker.com/get-started

下载 Download Docker Desktop for Windows-amd64(64 位)安装包。

网盘文件名:Docker安装包(windows).exe

安装docker

双击下载的安装包进行安装。

默认不需要进行额外配置,安装完成即可。

启动docker

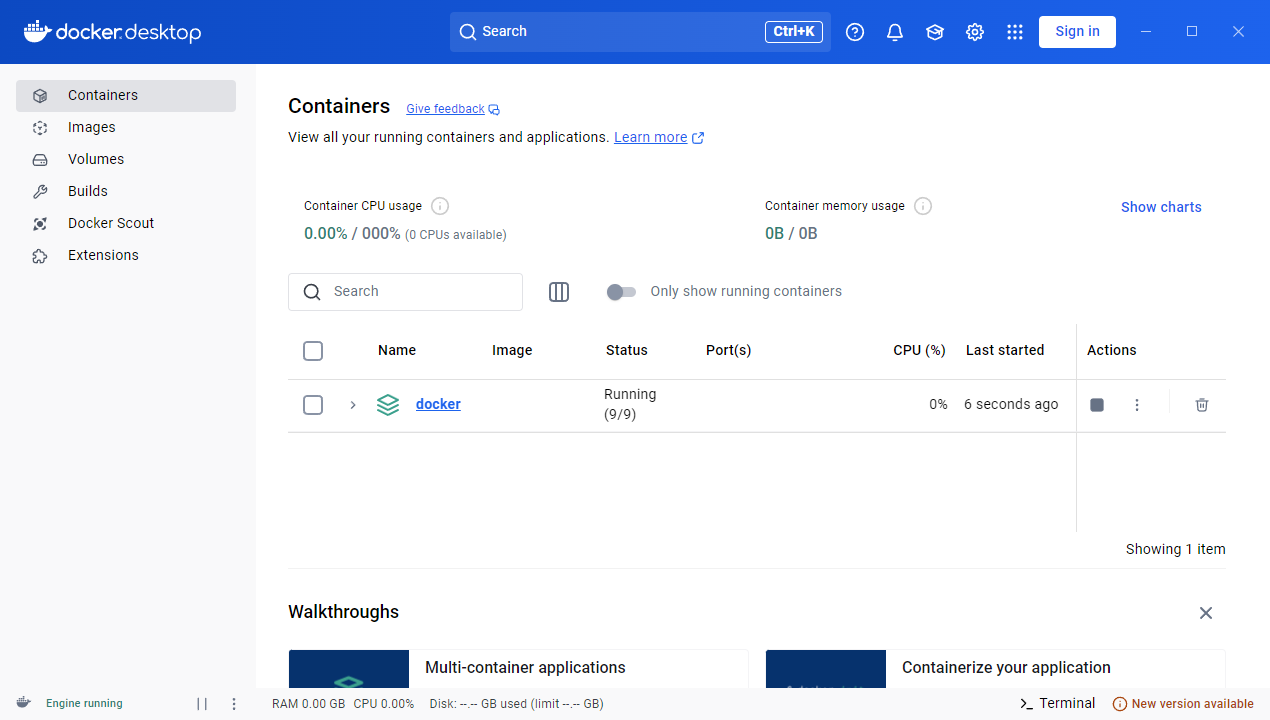

双击桌面上的 Docker Desktop 图标启动 Docker。

如果你的docker界面如下,证明docker安装成功。

3.使用ollama部署deepseek

参看此文档:https://www.eogee.com/article/detail/9

4.安装dify

下载dify安装包

访问dify的github并下载压缩包:https://github.com/langgenius/dify/archive/refs/tags/0.15.3.zip

网盘文件夹名:dify.zip

可以将此文件夹添加至任意目录下。

打开dify目录,找到docker目录,将.env.example文件重命名为.env,并修改其中的配置。

# 允许使用个人模型CUSTOM_MODEL_ENABLED = true# 配置模型路径OLLAMA_API_BASE_URL=host.docker.internal:11434安装dify依赖项目

在/dify/docker目录下,运行cmd或powershell运行以下命令安装 dify 依赖项目:

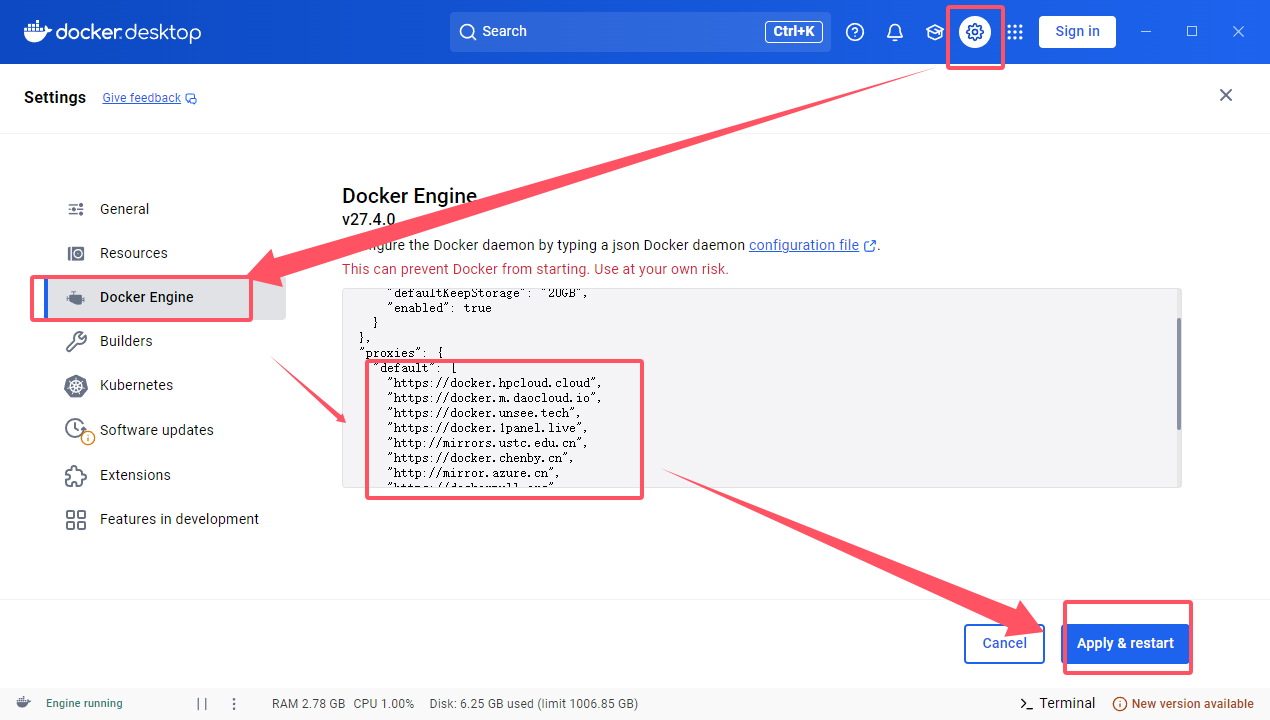

docker-compose up -d如果你在获取依赖过程中,多次尝试后仍然发生报错,你需要修改镜像代理,内容如下:(2025.02.15新增)

{ "registry-mirrors": [ "https://docker.1ms.run" ]}即为:打开docker->setting->docker engine->全选粘贴 ->apply

等待依赖项目安装完成。

启动dify

在浏览器中输入http://localhost/install

进入dify的注册页面。

设置任意邮箱和密码,进入登陆界面,输入注册时填写的信息点击登陆进入dify的工作台:

5.载入ollama及其模型

创建应用

登录dify的工作台,在左侧点击创建应用后,填写应用信息:

创建 后如果出现报错信息,建议关闭浏览器翻译功能或切换其他浏览器。

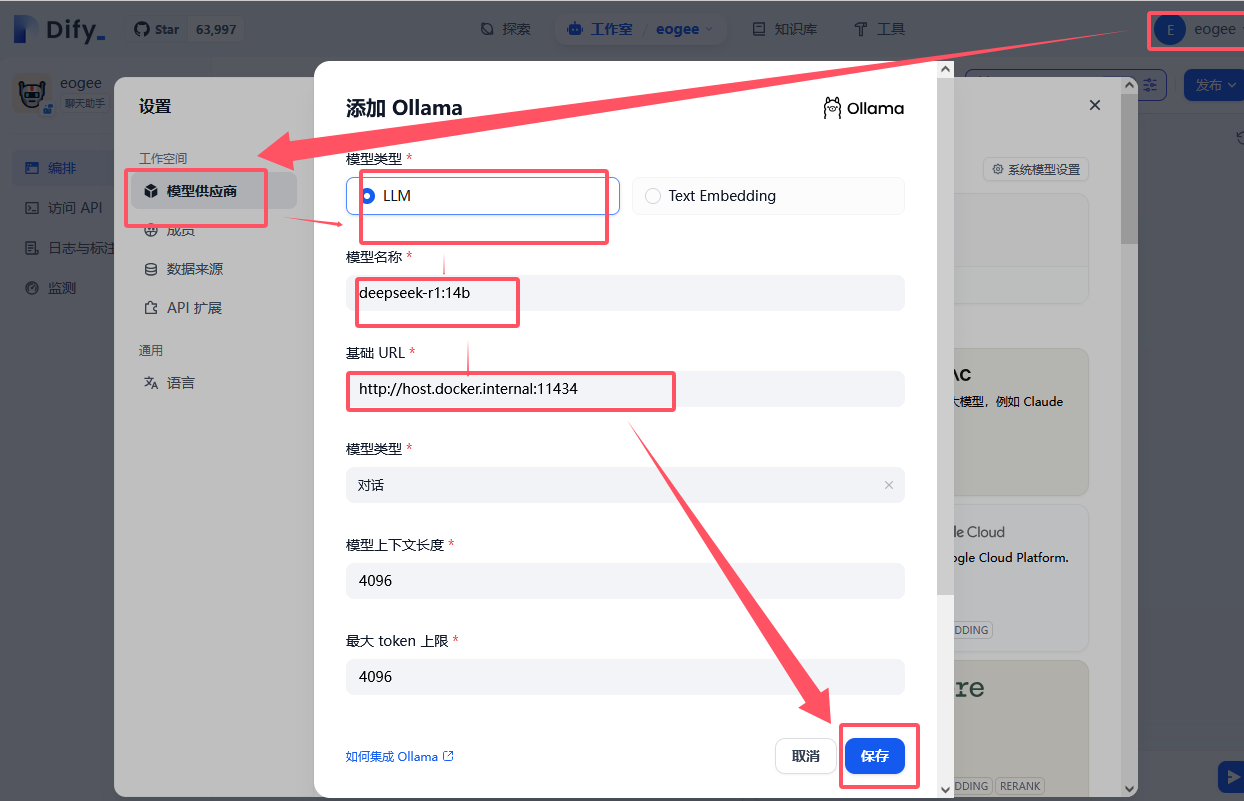

导入ollama及deepseek模型

导入大模型

跳转页面后点击右上角头像处,在下拉菜单中选择 设置 > 模型供应商 > ollama > 选择模型 > 填写模型名称 > 模型url(.env中配置的OLLAMA_API_BASE_URL = host.docker.internal:11434) > 点击导入按钮。

我们此处填写http://host.docker.internal:11434

导入完成后,刷新页面,ollama模型会出现在模型列表中。

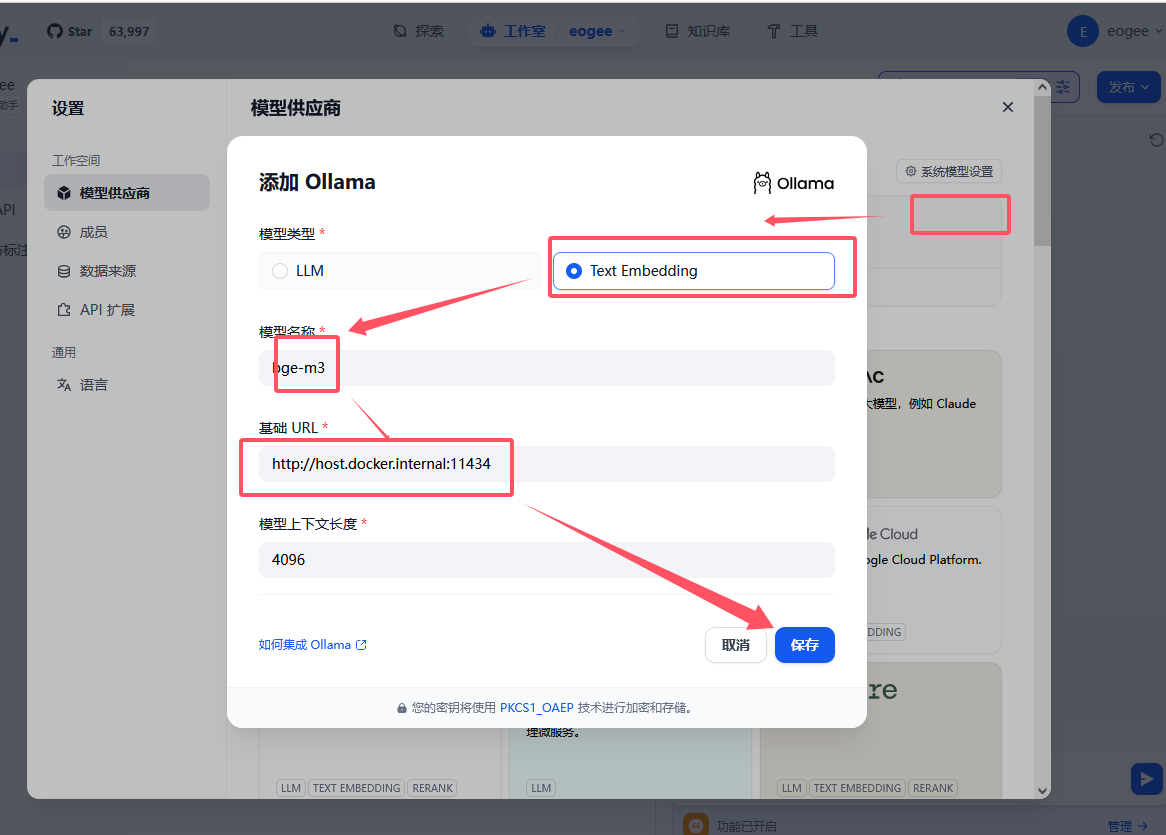

导入向量模型

这里以bge-m3为例,在ollama官网中,找到bge-m3模型,点击右侧复制命令,在cmd中运行命令:

ollama pull bge-m3模型下载完成后,回到dify界面,导入:

导入完成后,刷新页面,向量模型会出现在模型列表中。

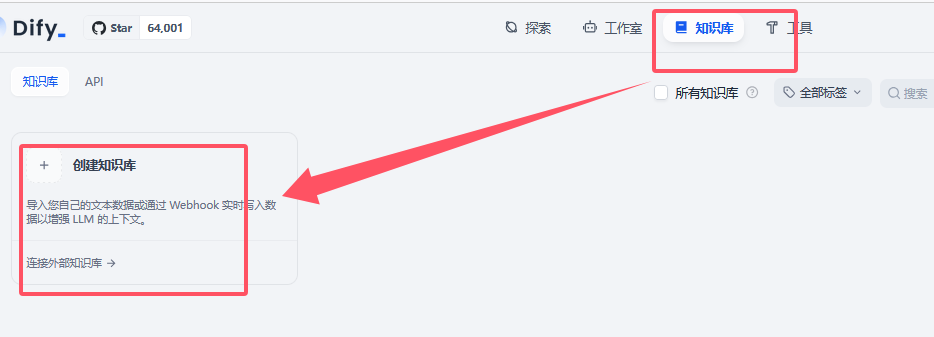

6.嵌入知识库

创建知识库

登录dify的工作台,点击左侧菜单栏中的 知识库 > 创建知识库,填写知识库信息:

创建完成后,点击知识库名称进入知识库编辑页面。

导入知识库

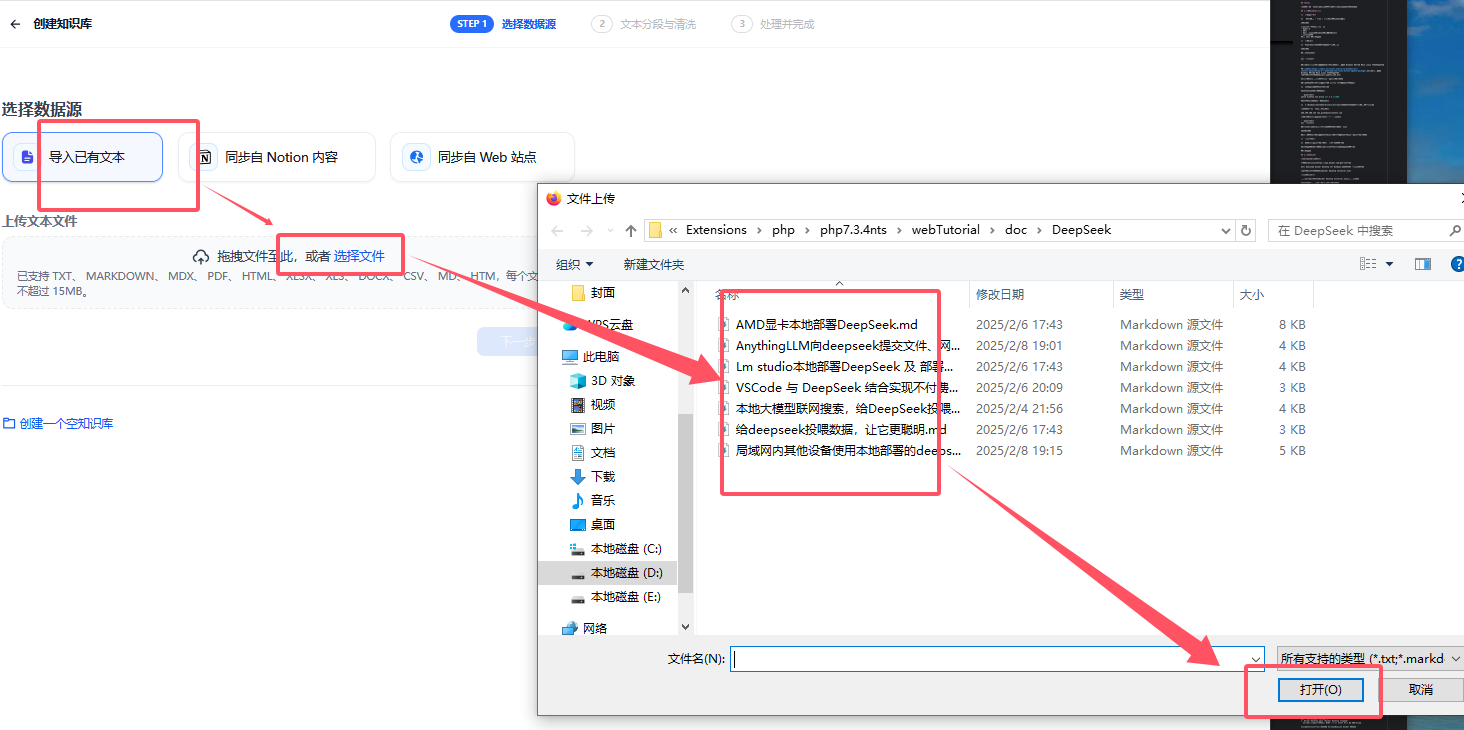

点击左侧菜单栏中的 导入 > 导入知识库,选择本地文件导入:

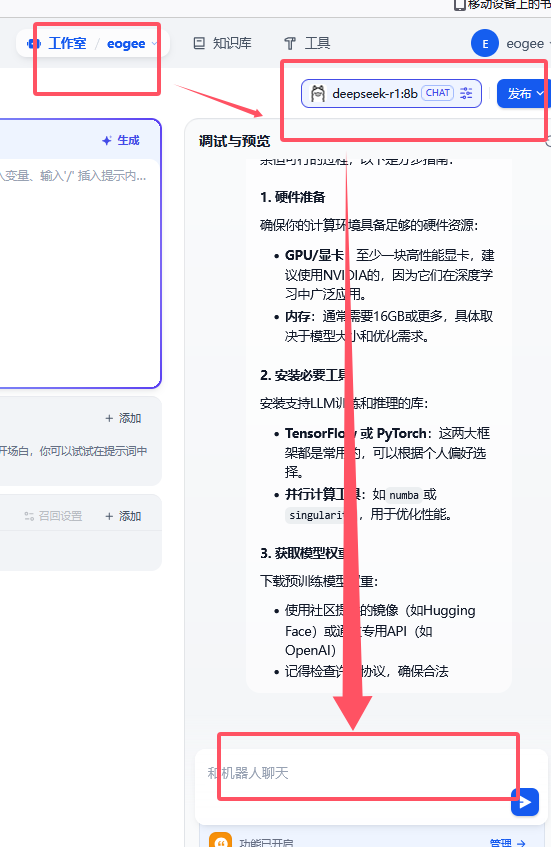

选择本地文件,点击导入按钮。待嵌入完成后,回到 工作室 界面,向其提问:

问题说明

windows系统安装docker,容易失败,甚至可能需要修改bios

注意浏览器的选择与使用,部分浏览器会报js错误

关于dify中工作流的应用,大家自行探索

目前dify还不支持lmstudio作为模型提供商,需要使用ollama